요즘 NLP와 전반적인 딥러닝에 대한 공부를 하는 중이다.

Transformer 모델이 너무 유명해서, 어쩌다 보니 Transformer의 attention 메커니즘이 사용된 모델들부터 공부하게 됐는데, 논문에서 이전 모델들에 대한 지식이 많이 쓰이는 것을 보고 아예 오래전 모델부터 공부해보고자 한다.

(사실 hidden state 과 back propagation 등에 관한 정확한 지식이 없어서, 이 부분에 대한 개념을 잡고 가야겠다고 생각했다.)

그리하여 이번에는 RNN의 개념을 집중해서 다뤄보고자 한다.

사실 LSTM 논문을 봤는데 정말 말도 안되는 수식들이 많았고, 이해하기가 너어무 어려워서 공부해야 겠다고 생각했다...

참고:

- [바람돌이/딥러닝] RNN(Recurrent Neural Network) - 순환 신경망 이론 및 개념|작성자 바람돌이

- https://velog.io/@cha-suyeon/%EC%98%A4%EC%B0%A8%EC%97%AD%EC%A0%84%ED%8C%8CBackpropagation

1. RNN의 등장 배경

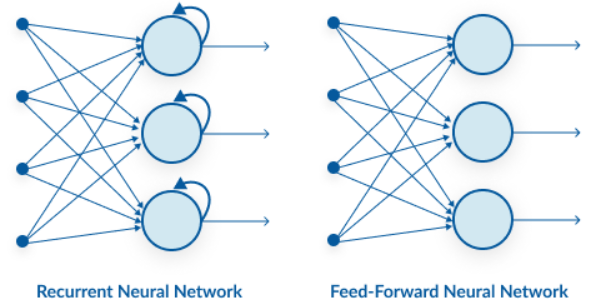

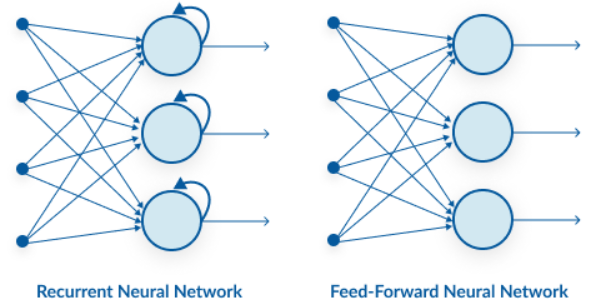

기존의 Neural Network는 이전에 일어난 사건을 바탕으로 이후에 일어나는 사건에 대해 예측하지 못한다. 은닉층(hidden layer)에서 활성화 함수를 지난 값은 무조건적으로 출력층(output layer) 방향으로 향하는 Feed-Forward의 특징을 지닌다.

이와 다르게 RNN은 hidden layer의 노드에서 활성화 함수를 통해 나온 결과값을 출력층 방향으로 보내면서, 다시 은닉층 노드의 다음 계산의 입력으로 가지는 특징을 가진다. 이와 같은 구조는 시계열 데이터 (Sequence Data)를 다루기에 적합한 구조이다.

2. RNN vs. ANN

위에서 설명했듯이, RNN은 순환 신경망으로써 인접한 다음 노드로만 계산되는 것이 아니라 자기 자신에게 혹은 그 전 노드로 계산되는 구조로 이루어진 Neural Network이다. 기존의 순방향 신경망 (Feed-Forward Network)와 아래 그림을 통해 비교해보자.

(아 그리고 Feed-Forward Network를 ANN이라고 많이들 부르더라.)

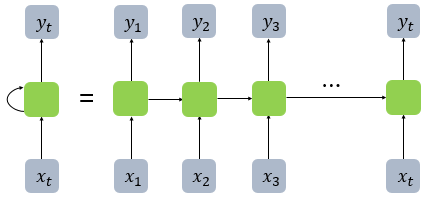

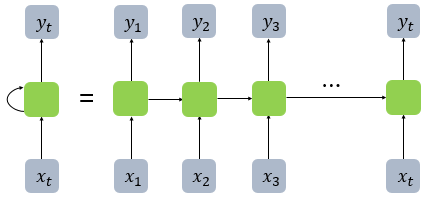

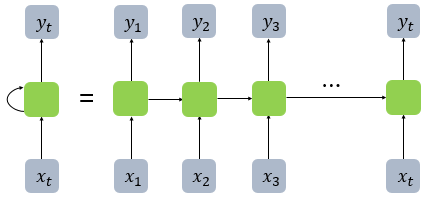

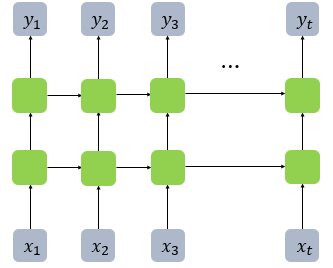

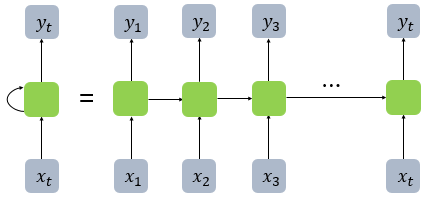

왼쪽 그림에서 보듯이, 이렇게 스스로 돌아가는 화살표를 관찰할 수 있다. 이는 다음 그림처럼 간소화해서 표현할 수도 있다.

위 그림에서 보듯이, 맨 마지막 cell (초록색 상자) h_t는 이전까지의 모든 정보들을 함축적으로 담고 있을 것이다.

결국 RNN에서 다음 시점의 정보는 전 시점의 정보만이 아니라 이전까지의 정보들을 모두 가지고 있을 것이다.

그리고 이처럼 정보를 가지고 있는 것을 cell이라고 하며 현재 cell이 가지고 있는 정보, 즉 다음 시점으로 넘겨줄 정보를 hidden state라고 한다.

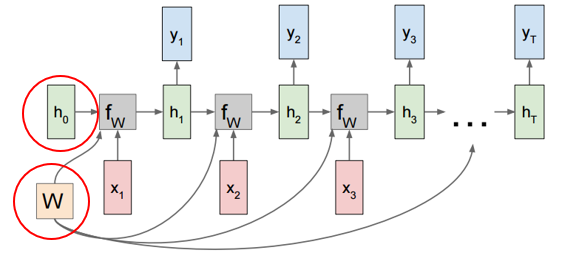

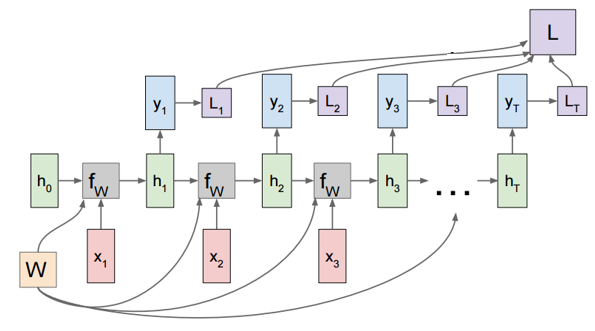

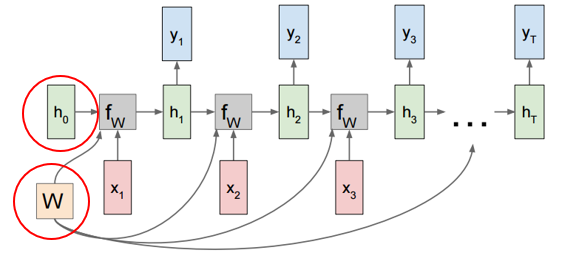

RNN의 cell들은 모두 같은 가중치 W를 공유한다는 특성이 있는데, 아래 그림에서 해당 개념을 잘 설명해준다.

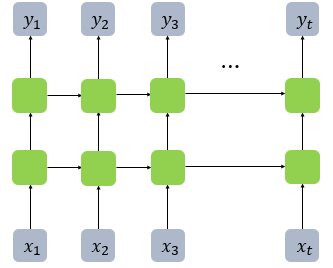

참고) 위 그림들은 하나의 cell만을 가지고 있는데, 아래 그림처럼 cell들을 많이 쌓아 올려서 더 깊은 구조를 만들 수도 있다.

3. RNN의 BPTT

기존의 back propagation은 다음 강의를 참고하면 매우 잘 이해할 수 있다: https://youtu.be/1Q_etC_GHHk

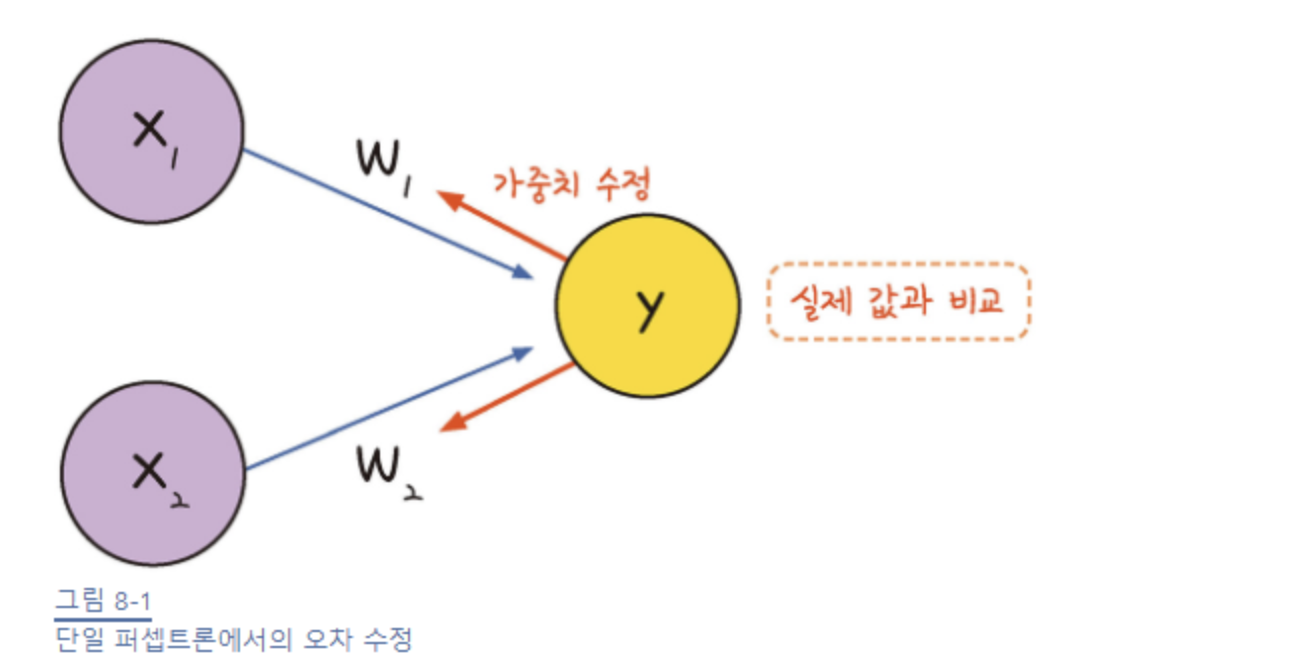

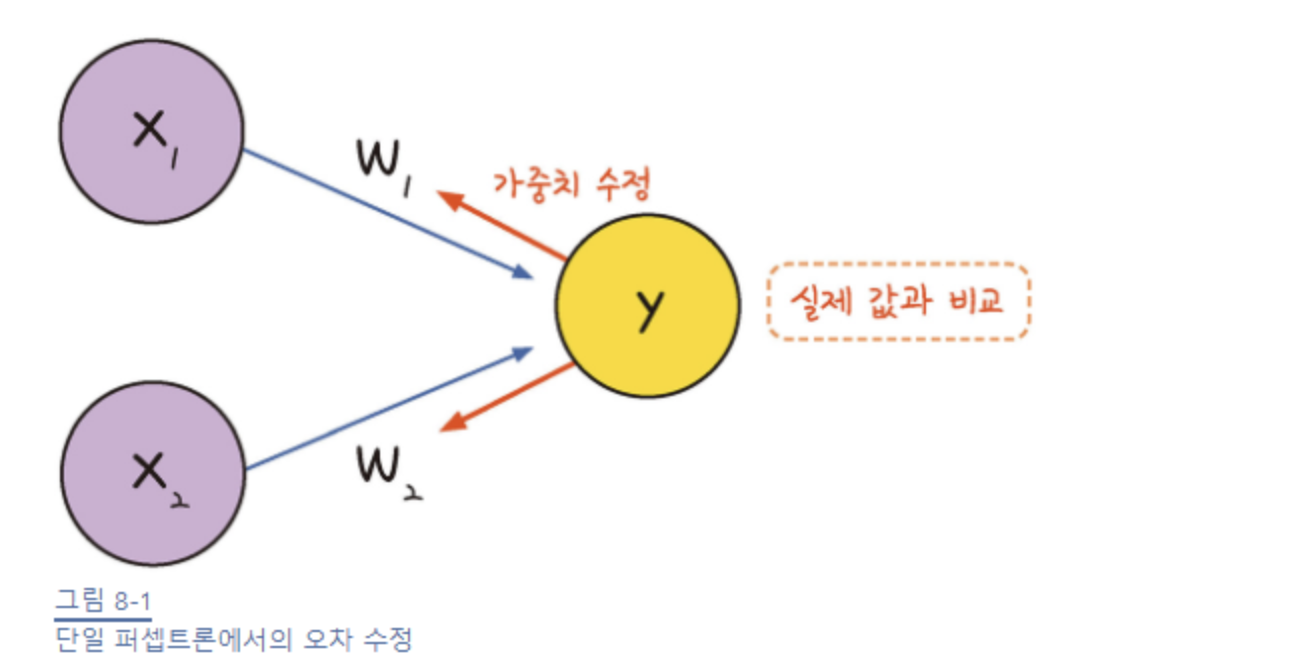

단일 퍼셉트론

단일 퍼셉트론에서는 결괏값을 얻으면 실제 값과의 비교를 통해 오차를 구하고, 이를 토대로 앞 단계에서 정한 가중치를 조정한다.

이는 다음과 같은 그림으로 나타낼 수 있다.

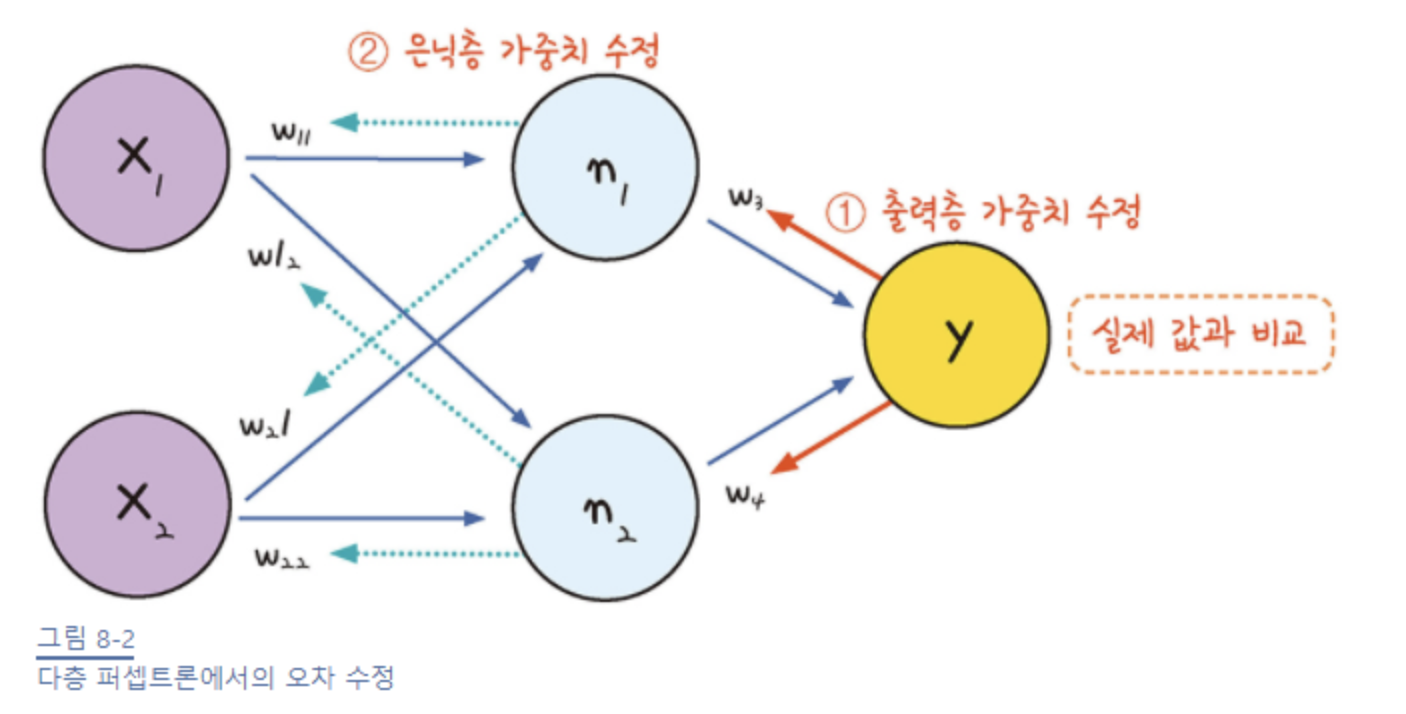

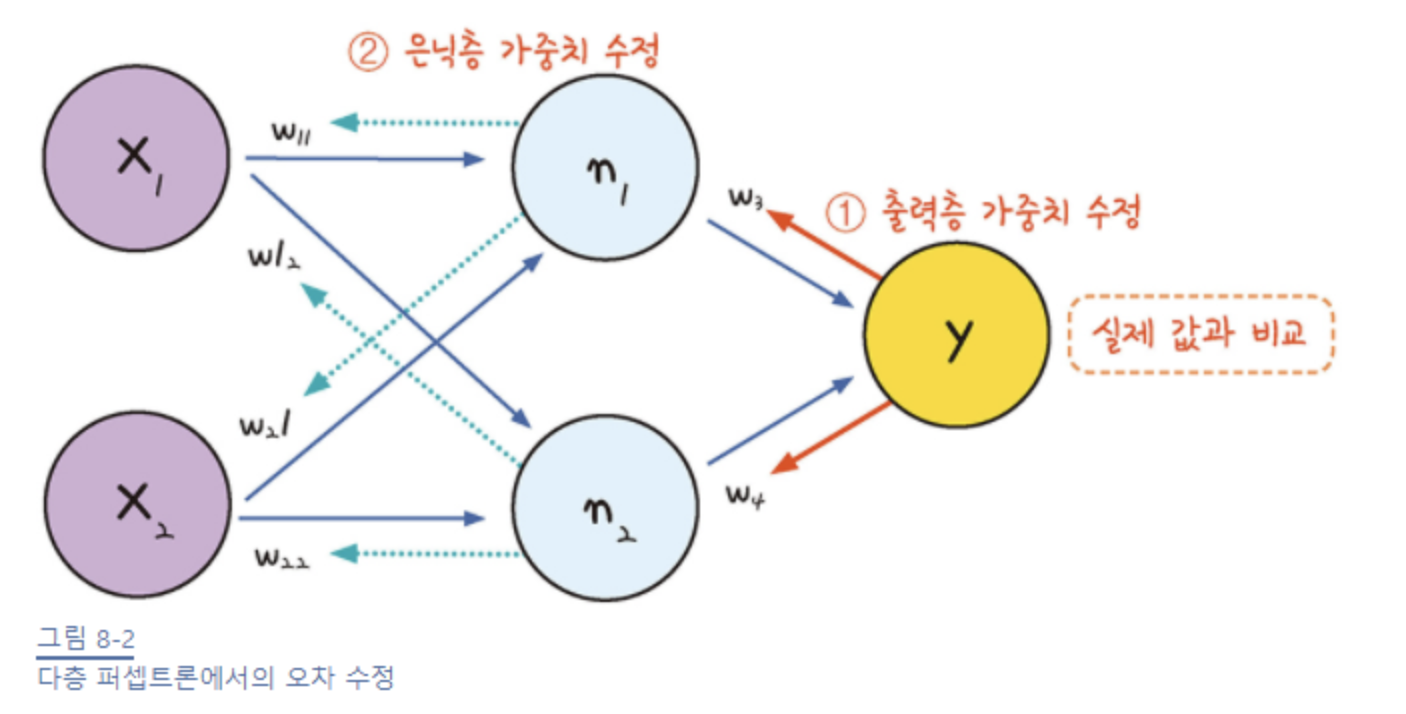

다층 퍼셉트론

마찬가지로, 다층 퍼셉트론 역시 결괏값의 오차를 구해 이를 토대로 하나 앞선 가중치를 차례로 거슬러 올라가며 조정해 간다.

- output layer의 가중치 수정

- hidden layer의 가중치 수정

그러다 보니 최적화의 계산 방향이 출력층에서 시작해 앞으로 진행된다.

그래서 다층 퍼셉트론에서의 최적화 과정을 오차 역전파(back propagation)이라 부른다.

그림에서는 다음과 같은 과정을 거친다:

- 임의의 초기 가중치(W)를 준 뒤 결과(y_out)을 계산한다.

- 계산 결과와 우리가 원하는 값 사이의 오차를 구한다.

- gradient descent를 이용해 바로 앞 가중치를 오차가 작아지는 방향으로 업데이트한다.

- 위 과정을 더이상 오차가 줄어들지 않을 때까지 반복한다.

나는 여기서 gradient descent로 어떻게 오차가 작아지는 방향으로 업데이트하지 ?? 라고 생각했는데, 이것의 의미는 미분 값이 0에 가까워지는 방향으로 나아간다는 말이었다.

즉, '기울기가 0이 되는 방향'으로 나아가야 하는데, 이 말은 가중치에서 기울기를 뺐을 때 가중치의 변화가 전혀 없는 상태를 말한다.

따라서 오차 역전파를 다른 방식으로 표현하면 가중치에서 기울기를 빼도 값의 변화가 없을 때까지 계속해서 가중치 수정 작업을 반복하는 것이다.

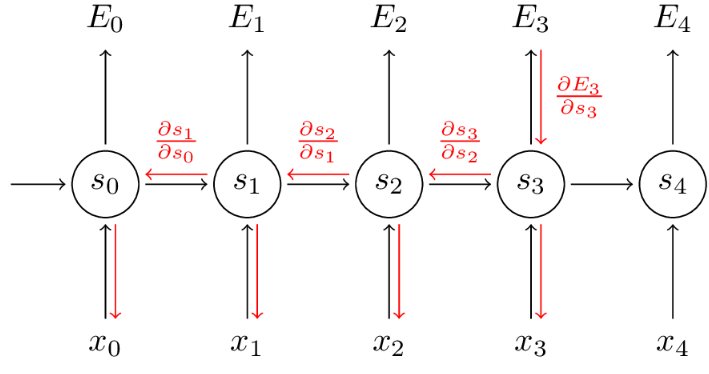

BPTT

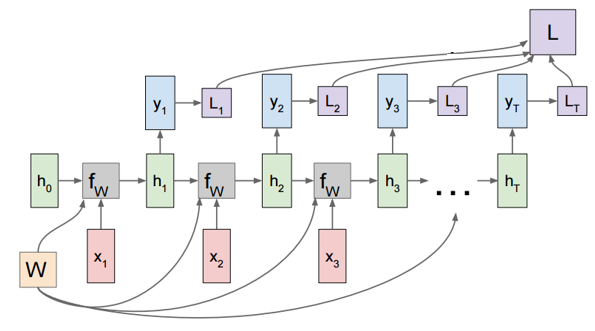

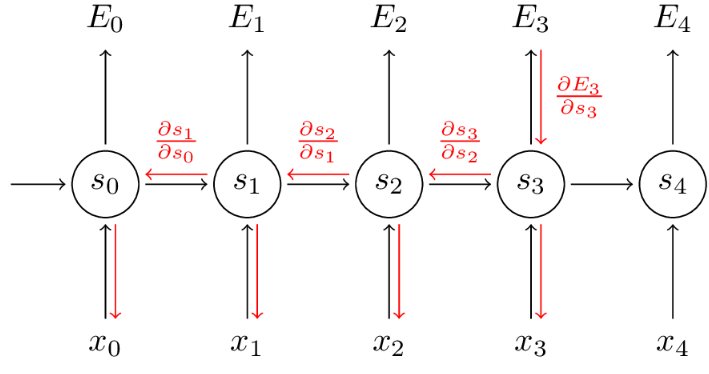

RNN에서는 동일한 히든 레이어가 반복되어 가중치 매트릭스를 공유하는 구조이기 때문에, gradient를 넘겨줄 때 현재 시간 단계만이 아니라 이전 시간의 단계를 고려해야 한다.

이러한 역전파 방식을 BPPT(BackPropagation Through Time)라고 한다.

RNN에서 전체 loss의 총합은 각 타임 스텝에서의 loss의 총합으로 나타낼 수 있는데, 그림은 다음과 같다:

RNN에서는 전체가 같은 가중치 W를 공유하기 때문에 각 타임 스텝의 gradient를 더해주어 학습시킬 수 있다.

그리고 예를 들어 t=3 타입 스텝에서 나온 결과는 t: 0~2까지의 결과에 의존하기 때문에 과거 시점까지 역전파해주는 것으로 볼 수 있다.

이러한 방식은 마찬가지로 미분의 chain rule로 발생한다.

4. RNN의 한계

이렇게 어렵게 고안해낸 RNN이고, 다양한 사용 분야가 있지만, 이런 RNN 또한 한계가 있었다.

그것은 바로 장기 의존성 문제(long-term dependecies)이다.

RNN은 비교적 짧은 시퀀스에서는 좋은 성능을 보이나, 타임 스텝이 커진다면 앞 쪽에 있는 정보들이 뒤쪽까지 충분히 전달되지 못한다.

이는 gradient의 전달되는 과정과 연관이 있다. RNN은 주로 tanh을 activation function사용하는데 이는 gradient vanishing 문제를 가지고 있다.

즉, 현 시점 t에 대한 loss를 학습하기 위해 이전의 정보들로까지 gradient를 전달해야 하는데 타임 스텝이 크다면 앞쪽까지 충분히 전달하지 못하는 것이다. 그래서 t시점에 오차에 대해 앞쪽에 있는 정보들이 활용될 수 없는 것이다.

이러한 문제점을 해결하기 위해 활성화함수를 Relu 등으로 사용하는 방법이 있으며 RNN을 개선한 LSTM, GRU 모델이 나왔다.

해당 모델들은 논문 리뷰 섹션에서 논문을 정리하며 개념도 함께 정리해볼 예정이다.

이렇게 오늘은 RNN에 관해 알아보았다.

워낙에 쓰이는 분야가 많아서 구조도 엄청 복잡할 것 같았지만, 생각보다는 복잡하지 않았던 것 같다.

다음의 내용들만 기억해 놓으면 좋을 것 같다:

- RNN은 순환 신경망으로써 인접한 다음 노드로만 계산되는 것이 아니라 자기 자신에게 혹은 그 전 노드로 계산되는 구조로 이루어진 Neural Network이다.

- RNN의 간소화 이미지

- RNN의 back propagation은 시간에 따라 진행되어 BPTT라고 불리는데, RNN에서는 전체가 모두 같은 가중치를 공유하므로 각 타임 스텝의 gradient를 더해주어 학습시킬 수 있다.

- RNN은 장기 의존성 문제가 있는데, 이는 활성 함수를 tanh 함수로 사용하면서 gradient가 소실되거나 폭발하여 생기는 문제이다.

'📚 스터디 > NLP' 카테고리의 다른 글

| [Word2Vec에 관하여] - CBOW, Skip-gram (0) | 2023.07.25 |

|---|---|

| [텍스트마이닝] 2-2. 문서 유사도 - 스타벅스 네이버 문서 유사도 구하기 (0) | 2023.06.19 |

| [텍스트마이닝] 2-1. 텍스트 표현과 문서 유사도 (0) | 2023.06.19 |

| [텍스트마이닝] 1. 텍스트 분석 (0) | 2023.06.17 |

요즘 NLP와 전반적인 딥러닝에 대한 공부를 하는 중이다.

Transformer 모델이 너무 유명해서, 어쩌다 보니 Transformer의 attention 메커니즘이 사용된 모델들부터 공부하게 됐는데, 논문에서 이전 모델들에 대한 지식이 많이 쓰이는 것을 보고 아예 오래전 모델부터 공부해보고자 한다.

(사실 hidden state 과 back propagation 등에 관한 정확한 지식이 없어서, 이 부분에 대한 개념을 잡고 가야겠다고 생각했다.)

그리하여 이번에는 RNN의 개념을 집중해서 다뤄보고자 한다.

사실 LSTM 논문을 봤는데 정말 말도 안되는 수식들이 많았고, 이해하기가 너어무 어려워서 공부해야 겠다고 생각했다...

참고:

- [바람돌이/딥러닝] RNN(Recurrent Neural Network) - 순환 신경망 이론 및 개념|작성자 바람돌이

- https://velog.io/@cha-suyeon/%EC%98%A4%EC%B0%A8%EC%97%AD%EC%A0%84%ED%8C%8CBackpropagation

1. RNN의 등장 배경

기존의 Neural Network는 이전에 일어난 사건을 바탕으로 이후에 일어나는 사건에 대해 예측하지 못한다. 은닉층(hidden layer)에서 활성화 함수를 지난 값은 무조건적으로 출력층(output layer) 방향으로 향하는 Feed-Forward의 특징을 지닌다.

이와 다르게 RNN은 hidden layer의 노드에서 활성화 함수를 통해 나온 결과값을 출력층 방향으로 보내면서, 다시 은닉층 노드의 다음 계산의 입력으로 가지는 특징을 가진다. 이와 같은 구조는 시계열 데이터 (Sequence Data)를 다루기에 적합한 구조이다.

2. RNN vs. ANN

위에서 설명했듯이, RNN은 순환 신경망으로써 인접한 다음 노드로만 계산되는 것이 아니라 자기 자신에게 혹은 그 전 노드로 계산되는 구조로 이루어진 Neural Network이다. 기존의 순방향 신경망 (Feed-Forward Network)와 아래 그림을 통해 비교해보자.

(아 그리고 Feed-Forward Network를 ANN이라고 많이들 부르더라.)

왼쪽 그림에서 보듯이, 이렇게 스스로 돌아가는 화살표를 관찰할 수 있다. 이는 다음 그림처럼 간소화해서 표현할 수도 있다.

위 그림에서 보듯이, 맨 마지막 cell (초록색 상자) h_t는 이전까지의 모든 정보들을 함축적으로 담고 있을 것이다.

결국 RNN에서 다음 시점의 정보는 전 시점의 정보만이 아니라 이전까지의 정보들을 모두 가지고 있을 것이다.

그리고 이처럼 정보를 가지고 있는 것을 cell이라고 하며 현재 cell이 가지고 있는 정보, 즉 다음 시점으로 넘겨줄 정보를 hidden state라고 한다.

RNN의 cell들은 모두 같은 가중치 W를 공유한다는 특성이 있는데, 아래 그림에서 해당 개념을 잘 설명해준다.

참고) 위 그림들은 하나의 cell만을 가지고 있는데, 아래 그림처럼 cell들을 많이 쌓아 올려서 더 깊은 구조를 만들 수도 있다.

3. RNN의 BPTT

기존의 back propagation은 다음 강의를 참고하면 매우 잘 이해할 수 있다: https://youtu.be/1Q_etC_GHHk

단일 퍼셉트론

단일 퍼셉트론에서는 결괏값을 얻으면 실제 값과의 비교를 통해 오차를 구하고, 이를 토대로 앞 단계에서 정한 가중치를 조정한다.

이는 다음과 같은 그림으로 나타낼 수 있다.

다층 퍼셉트론

마찬가지로, 다층 퍼셉트론 역시 결괏값의 오차를 구해 이를 토대로 하나 앞선 가중치를 차례로 거슬러 올라가며 조정해 간다.

- output layer의 가중치 수정

- hidden layer의 가중치 수정

그러다 보니 최적화의 계산 방향이 출력층에서 시작해 앞으로 진행된다.

그래서 다층 퍼셉트론에서의 최적화 과정을 오차 역전파(back propagation)이라 부른다.

그림에서는 다음과 같은 과정을 거친다:

- 임의의 초기 가중치(W)를 준 뒤 결과(y_out)을 계산한다.

- 계산 결과와 우리가 원하는 값 사이의 오차를 구한다.

- gradient descent를 이용해 바로 앞 가중치를 오차가 작아지는 방향으로 업데이트한다.

- 위 과정을 더이상 오차가 줄어들지 않을 때까지 반복한다.

나는 여기서 gradient descent로 어떻게 오차가 작아지는 방향으로 업데이트하지 ?? 라고 생각했는데, 이것의 의미는 미분 값이 0에 가까워지는 방향으로 나아간다는 말이었다.

즉, '기울기가 0이 되는 방향'으로 나아가야 하는데, 이 말은 가중치에서 기울기를 뺐을 때 가중치의 변화가 전혀 없는 상태를 말한다.

따라서 오차 역전파를 다른 방식으로 표현하면 가중치에서 기울기를 빼도 값의 변화가 없을 때까지 계속해서 가중치 수정 작업을 반복하는 것이다.

BPTT

RNN에서는 동일한 히든 레이어가 반복되어 가중치 매트릭스를 공유하는 구조이기 때문에, gradient를 넘겨줄 때 현재 시간 단계만이 아니라 이전 시간의 단계를 고려해야 한다.

이러한 역전파 방식을 BPPT(BackPropagation Through Time)라고 한다.

RNN에서 전체 loss의 총합은 각 타임 스텝에서의 loss의 총합으로 나타낼 수 있는데, 그림은 다음과 같다:

RNN에서는 전체가 같은 가중치 W를 공유하기 때문에 각 타임 스텝의 gradient를 더해주어 학습시킬 수 있다.

그리고 예를 들어 t=3 타입 스텝에서 나온 결과는 t: 0~2까지의 결과에 의존하기 때문에 과거 시점까지 역전파해주는 것으로 볼 수 있다.

이러한 방식은 마찬가지로 미분의 chain rule로 발생한다.

4. RNN의 한계

이렇게 어렵게 고안해낸 RNN이고, 다양한 사용 분야가 있지만, 이런 RNN 또한 한계가 있었다.

그것은 바로 장기 의존성 문제(long-term dependecies)이다.

RNN은 비교적 짧은 시퀀스에서는 좋은 성능을 보이나, 타임 스텝이 커진다면 앞 쪽에 있는 정보들이 뒤쪽까지 충분히 전달되지 못한다.

이는 gradient의 전달되는 과정과 연관이 있다. RNN은 주로 tanh을 activation function사용하는데 이는 gradient vanishing 문제를 가지고 있다.

즉, 현 시점 t에 대한 loss를 학습하기 위해 이전의 정보들로까지 gradient를 전달해야 하는데 타임 스텝이 크다면 앞쪽까지 충분히 전달하지 못하는 것이다. 그래서 t시점에 오차에 대해 앞쪽에 있는 정보들이 활용될 수 없는 것이다.

이러한 문제점을 해결하기 위해 활성화함수를 Relu 등으로 사용하는 방법이 있으며 RNN을 개선한 LSTM, GRU 모델이 나왔다.

해당 모델들은 논문 리뷰 섹션에서 논문을 정리하며 개념도 함께 정리해볼 예정이다.

이렇게 오늘은 RNN에 관해 알아보았다.

워낙에 쓰이는 분야가 많아서 구조도 엄청 복잡할 것 같았지만, 생각보다는 복잡하지 않았던 것 같다.

다음의 내용들만 기억해 놓으면 좋을 것 같다:

- RNN은 순환 신경망으로써 인접한 다음 노드로만 계산되는 것이 아니라 자기 자신에게 혹은 그 전 노드로 계산되는 구조로 이루어진 Neural Network이다.

- RNN의 간소화 이미지

- RNN의 back propagation은 시간에 따라 진행되어 BPTT라고 불리는데, RNN에서는 전체가 모두 같은 가중치를 공유하므로 각 타임 스텝의 gradient를 더해주어 학습시킬 수 있다.

- RNN은 장기 의존성 문제가 있는데, 이는 활성 함수를 tanh 함수로 사용하면서 gradient가 소실되거나 폭발하여 생기는 문제이다.

'📚 스터디 > NLP' 카테고리의 다른 글

| [Word2Vec에 관하여] - CBOW, Skip-gram (0) | 2023.07.25 |

|---|---|

| [텍스트마이닝] 2-2. 문서 유사도 - 스타벅스 네이버 문서 유사도 구하기 (0) | 2023.06.19 |

| [텍스트마이닝] 2-1. 텍스트 표현과 문서 유사도 (0) | 2023.06.19 |

| [텍스트마이닝] 1. 텍스트 분석 (0) | 2023.06.17 |