이번 방학 때 NLP 관련 개념을 확실하게 잡고자 CS224N 강의를 수강해야겠다고 생각했다.

CS~N 강의는 스탠포드에서 가르치는 CS 강의 종류인 것 같은데,

대표적으로는 머신/딥러닝 기초 강의인 CS231N이 있고, 나도 듣다가 말았었다..(너무 길어)

이 강의는 2년에 한번씩 업데이트되는 것 같은데, 나는 2021 Winter 강의를 수강했다. [유튜브 플레이리스트]

첫 강의의 주제는 사람의 언어와 단어 의미에 관한 내용이다.

흔히, 우리가 사용하는 단어들을 컴퓨터가 직관적으로 알아듣기는 어렵다.

이를 위해 단어들을 숫자로 이루어진 벡터들로 변환시켜주어야 한다.

How to represent the meaning of the word?

그렇다면 단어의 의미를 어떻게 나타낼 수 있을까?

1. Wordnet

Wordnet은 동의어, 상하관계 언어의 집합이다. 다음 예시를 참고하자.

이와 같은 WordNet의 단점은 다음과 같다:

- 뉘앙스 (단어의 사용 맥락)를 반영하지 못한다.

- 단어들의 새로운 의미를 알기 어렵다 (최신 정보 유지 불가)

- 판단 기준이 주관적이다.

- 단어 의미 간의 유사성을 파악하기 어렵다.

2. One-hot vector

두 번째는 one-hot vector 표현 방식이다.

이는 데이터 분석에도 많이 쓰이는 one-hot encoding 방식과 거의 유사하다.

이 방식은 범주형 벡터에서 모든 변수를 0과 1의 열거형으로 만들어 표현하는 방식이다. 다음 예시를 참고하자.

위 그림과 같이, 단어들이 여러개 있을 때, 한 단어들이 있는 자리에 1을, 없는 자리에 0을 넣음으로써 표현할 수 있다.

One-hot vector 표현방식의 단점은 다음과 같다:

- 단어의 개수와 vector의 개수가 같으므로, 큰 차원이 필요하다.

- 단어 관계의 파악을 위해서는 제곱이 필요하며, 어려워진다.

최종적으로 나온 결론은, Vector 스스로가 유사성을 계산할 수 있도록 하자 !! 는 것이다.

3. Distributional semantics

그 방식이 distributional semantics, 한국어로는 분포 의미론 이라고도 한다더라.

위 두 가지 방식의 문제점을 개선한 방법으로, 단어의 문맥을 고려한 방식이다.

이 방식은 fixed window size를 통해 단어를 표현할 때 주위 context를 살펴서 비슷한 문맥에서 나타나는 단어들은 서로 비슷한 벡터를 가지도록 한다.

우리는 이렇게 생성된 word vectors를 word embeddings, word representations라고 부른다.

Word2Vec

word2vec은 word vector들의 학습을 위해 만들어진 프레임워크이다.

1. 아이디어

word2vec 프레임워크의 아이디어는 다음과 같다:

- 충분한 양의 텍스트 corpus (말뭉치)가 있고, 모든 각각의 단어는 벡터로 나타내질 수 있다.

- 텍스트의 포지션 t를 거치는데, 여기에는 중심 단어 c와 외부 단어 o가 있다.

- c와 o의 word vector의 유사성을 이용하여 확률을 계산한다.

- 이 확률을 최대화시키기 위해 word vector를 갱신시킨다.

2. 과정

이 개념을 시각화해서 과정을 보면 다음과 같다:

1) 현재 위치 t에 있는 단어를 , 주변에 있는 단어를 , 이라고 할 때 , 를 구한다.

2) , 를 최대화하는 vector를 찾는다.

3) corpus 안의 모든 단어에 대해 1~2 단계를 거친다.

3. 목적 함수 (objective function) 최적화

1. Likelihood

이 함수는 word vector 𝜽가 주어졌을 때, window 내의 context word가 해당 위치에 나타날 확률의 곱이다.

식을 말로 풀어 쓰면, 각 단어를 중심 단어로 사용하는 곱을 취한 후, 각 단어의 곱과 중심 단어에서 해당 문맥 단어를 예측할 확률을 주변의 창을 사용하여 계산하는 방식이 된다.

2. Objective function

Objective function, 목적 함수의 더 와닿는 이름은 loss function, cost function인 것 같다.

아무튼 여기서의 object function은 다음과 같다:

여기서 목적 함수는 손실 함수이므로, 목적 함수를 최소화시키는 것이 예측 확률을 높이는 것이다.

그러니 우리의 목표는 J(𝜽)를 최소화시키는 것이다.

3. Predict function

Q: 중심 단어가 주어진 경우, 문맥에서 나타나는 단어의 확률을 어떻게 계산할 수 있을까 ?

A: 우리는 한 단어에 대해 두 개의 vector을 사용할 예정이다.

하나는 해당 단어가 center word(중심 단어)일 경우 (이를 v_w 라고 표현한다),

다른 하나는 해당 단어가 context word(문맥 단어)일 경우 (이를 u_w 라고 표현한다)이다.

이에 기반하면 문맥 단어가 나타날 확률 P(o|c)는 다음과 같다:

이 함수를 한번 해석해보자.

우선 분자. exp(u_o T v_c)는 내적으로 o와 c의 유사성을 비교하여 내적 값이 크면 유사하다는 것을 나타낸다.

이때, exp를 취해주는 이유는 내적값이 음수가 나올 수 있으므로, 양수로 바꿔주기 위함이다.

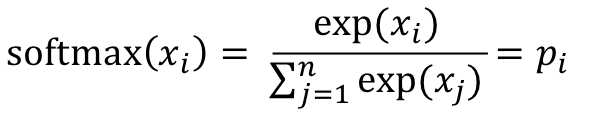

다음은 분모. 이와 관련해서는 우선 softmax 함수 식을 볼 필요가 있다.

softmax 함수는 어떠한 값 R에 대해 이 값을 0과 1 사이의 값으로 변환하는 것을 의미한다.

분모에서는 확률 분배를 위해 전체 단어들에 대해 normalize 한다.

4. Optimization

최종적으로는, 위에서 설명된 함수들을 종합하여 최적화한다.

위 식에서, 목적 함수를 최소화하는 𝜽, 즉 u 와 v를 찾는다.

이 과정에서 미분 과정을 화이트보드를 통해 직접 설명해주시는데, 나는 사진만 첨부하고 넘어가겠다. 그냥 미분하는거다.

최종 결과로 𝜽를 찾으면 V개의 단어가 존재하고, 𝜽가 d-dimension vector일 때,

word vector는 u, v를 포함하므로 2dV 차원을 갖는다.

이렇듯, 이번 단원에서는 단어를 기본적으로 표현하는 방식과,

word2vec 프레임워크의 구성에 관해 알아보았다.

'📚 스터디 > CS224N' 카테고리의 다른 글

| [CS224N] 6, 7, 8. RNN, LSTM, Seq2seq, Attention & Transformers (1) | 2023.12.30 |

|---|---|

| [CS224N] 5. Language Models and Recurrent Neural Networks (2) | 2023.11.20 |

| [CS224N] 4. Syntactic Structure and Dependency Parsing (0) | 2023.11.18 |

| [CS224N] 3. Natural Language Processing with Deep Learning (1) | 2023.11.14 |

| [CS224N] 2. Neural Classifiers (0) | 2023.08.02 |